یکی از چالشهای جدی در استفاده از مدلهای زبانی هوش مصنوعی، مسئلهای است که پژوهشگران آن را «توهم هوش مصنوعی» مینامند. این پدیده زمانی رخ میدهد که یک مدل، اطلاعات نادرست یا بدون منبع معتبر را بهعنوان حقیقت ارائه میکند.

مطالعات اخیر نشان دادهاند که بسیاری از مدلهای پرکاربرد هنگام شناسایی و استناد به منابع خبری، دچار خطاهای گسترده میشوند. در این بررسی، از مدلها خواسته شد متنهای خبری را تحلیل کرده و مقاله، رسانه و آدرس اینترنتی اصلی را مشخص کنند. نکته مهم این بود که منابع انتخابی بهگونهای بودند که در نتایج ابتدایی جستجوی گوگل قابل مشاهده باشند.

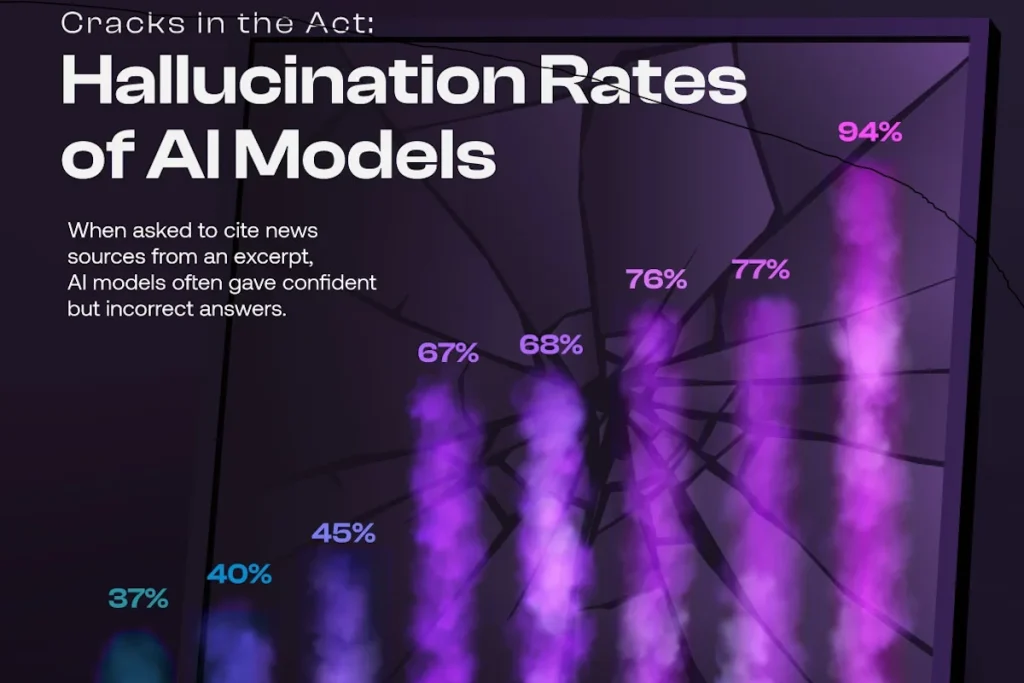

نتایج نشان داد تفاوت عملکرد میان مدلها بسیار چشمگیر است. برای نمونه، Grok‑3 با نرخ خطای ۹۴ درصد بدترین عملکرد را داشت؛ به این معنا که تقریباً تمام پاسخهای آن اشتباه یا ناقص بودند. در مقابل، Perplexity با نرخ ۳۷ درصد کمترین میزان توهم را ثبت کرد و دقیقترین پاسخها را ارائه داد.

جدول زیر خلاصهای از نتایج را نشان میدهد:

- Perplexity: ۳۷٪

- Copilot: ۴۰٪

- Perplexity Pro: ۴۵٪

- ChatGPT Search: ۶۷٪

- Deepseek Search: ۶۸٪

- Gemini: ۷۶٪

- Grok‑2 Search: ۷۷٪

- Grok‑3 Search: ۹۴٪

این یافتهها نکته جالبی را آشکار میکنند: نسخههای پولی برخی مدلها حتی ضعیفتر از نسخههای رایگان عمل کردهاند. علاوه بر این، اکثر مدلها با وجود خطاهای فراوان، هیچ نشانهای از عدم اطمینان در پاسخهایشان ارائه نکردند؛ گویی همه چیز را با قطعیت بیان میکنند.

پژوهشگران توضیح میدهند که دلیل اصلی این وضعیت به شیوه آموزش مدلها برمیگردد. در سیستمهای آموزشی رایج، «حدس زدن» بهجای اعلام ناتوانی یا عدم اطمینان، پاداش داده میشود. درست مانند آزمون چندگزینهای که پاسخ دادن—even اگر اشتباه باشد—بیشتر از خالی گذاشتن سؤال امتیاز دارد.

این نتایج نشان میدهد که برای اعتماد به خروجی هوش مصنوعی، تنها اتکا به پاسخ مدل کافی نیست. کاربران باید همواره به دنبال منابع معتبر باشند و بدانند که «حقیقت» ارائهشده توسط این سیستمها ممکن است چیزی جز یک توهم محاسباتی نباشد.